-

#Cannes Lions Festival

Das sind die deutschen Young Lions 2024 Der deutsche Cannes Lions Festivalrepräsentant Weischer entsendet 12 junge Talente …

#Cannes Lions Festival

Das sind die deutschen Young Lions 2024 Der deutsche Cannes Lions Festivalrepräsentant Weischer entsendet 12 junge Talente …

-

#Kinowerbung

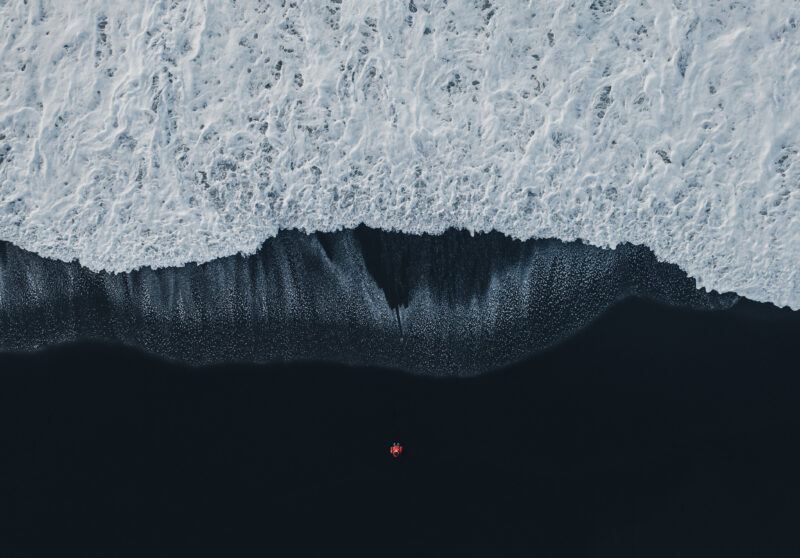

The Big Outdoor Die Abende werden länger und wärmer. Der Sommer kündigt sich …

#Kinowerbung

The Big Outdoor Die Abende werden länger und wärmer. Der Sommer kündigt sich …

-

#Cannes Lions Festival

Deutsche Cannes Lions Juror:innen 2024 Die deutschen Awarding Juror:innen des Cannes Lions Festivals stehen fest. …

#Cannes Lions Festival

Deutsche Cannes Lions Juror:innen 2024 Die deutschen Awarding Juror:innen des Cannes Lions Festivals stehen fest. …

-

#Social Media #Corporate News

Weischer gründet Social Media Agentur Mit Weischer.Connect zählt ab sofort auch eine Social Media Agentur zur Unternehmensgruppe. Neuer CEO ist Björn Wenzel.

#Social Media #Corporate News

Weischer gründet Social Media Agentur Mit Weischer.Connect zählt ab sofort auch eine Social Media Agentur zur Unternehmensgruppe. Neuer CEO ist Björn Wenzel.

-

#Out-of-Home #Corporate News

Weischer.JvB inszeniert erste KI-Kampagne für Dolomiti Superski Weischer.JvB führt mit Dolomiti Superski die erste deutschlandweite DOOH-Kampagne mit KI-gesteuerter Zielgruppenanalyse und Motivausspielung ein.

#Out-of-Home #Corporate News

Weischer.JvB inszeniert erste KI-Kampagne für Dolomiti Superski Weischer.JvB führt mit Dolomiti Superski die erste deutschlandweite DOOH-Kampagne mit KI-gesteuerter Zielgruppenanalyse und Motivausspielung ein.

-

#Kinowerbung

Kino ist das ganze Jahr Das Kinojahr 2024 wird für reichlich Abwechslung und Wiedersehensfreude sorgen.

#Kinowerbung

Kino ist das ganze Jahr Das Kinojahr 2024 wird für reichlich Abwechslung und Wiedersehensfreude sorgen.

-

#Cannes Lions Festival

Young Lions Competition 2024 Bewerbungsphase gestartet Der Cannes Lions Festivalrepräsentant Weischer ist erneut auf der Suche …

#Cannes Lions Festival

Young Lions Competition 2024 Bewerbungsphase gestartet Der Cannes Lions Festivalrepräsentant Weischer ist erneut auf der Suche …

-

#Out-of-Home

Weischer.JvB führt in (D)OOH KI-basierte Kampagnenplanung ein Zäsur in der Planung von Außenwerbung: Weischer.JvB launcht ein KI-gestütztes …

#Out-of-Home

Weischer.JvB führt in (D)OOH KI-basierte Kampagnenplanung ein Zäsur in der Planung von Außenwerbung: Weischer.JvB launcht ein KI-gestütztes …

-

#Corporate News #Verantwortung

Weischer – Neue Initiativen bei Nachhaltigkeit Das Medienunternehmen Weischer speist seinen Nachhaltigkeitsbericht 2022 über ein eigenes …

#Corporate News #Verantwortung

Weischer – Neue Initiativen bei Nachhaltigkeit Das Medienunternehmen Weischer speist seinen Nachhaltigkeitsbericht 2022 über ein eigenes …

-

#Corporate News #Cannes Lions Festival

Nacht der Löwen 2023 in Hamburg Feierliche Preisverleihung für die besten Werber:innen Deutschlands: Das Hamburger Medienunternehmen …

#Corporate News #Cannes Lions Festival

Nacht der Löwen 2023 in Hamburg Feierliche Preisverleihung für die besten Werber:innen Deutschlands: Das Hamburger Medienunternehmen …

-

#Corporate News #Kinowerbung

Die junge Zielgruppe feiert das Kino Noch nie haben Social Media-Trends das Besucherverhalten im Kino stärker …

#Corporate News #Kinowerbung

Die junge Zielgruppe feiert das Kino Noch nie haben Social Media-Trends das Besucherverhalten im Kino stärker …

-

#Cannes Lions Festival

Das sind die deutsche Juror:innen der Eurobest 2023 Mit insgesamt 10 Jurymitglieder und zwei Jurypräsident:innen ist Deutschland wieder …

#Cannes Lions Festival

Das sind die deutsche Juror:innen der Eurobest 2023 Mit insgesamt 10 Jurymitglieder und zwei Jurypräsident:innen ist Deutschland wieder …

-

#Corporate News #Kinowerbung

Weischer.Cinema zündet zweite Programmatic-Stufe Mit „Programmatic Flex Targeting“ können Zielgruppen im Kino jetzt auch …

#Corporate News #Kinowerbung

Weischer.Cinema zündet zweite Programmatic-Stufe Mit „Programmatic Flex Targeting“ können Zielgruppen im Kino jetzt auch …

-

#Corporate News #Kinowerbung

Kino setzt ein Zeichen für Brand Safety Kinowerbung wird noch transparenter: Durch eine enge Kooperation des Kinowerbeverbands …

#Corporate News #Kinowerbung

Kino setzt ein Zeichen für Brand Safety Kinowerbung wird noch transparenter: Durch eine enge Kooperation des Kinowerbeverbands …

-

#Cannes Lions Festival

Deutsche Cannes Lions Juror:innen 2023 Das sind die 19 deutschen Juror:innen, die 2023 ihre Expertise in die Fachjurys des Cannes Lions Festival of Creativity einfließen lassen!

#Cannes Lions Festival

Deutsche Cannes Lions Juror:innen 2023 Das sind die 19 deutschen Juror:innen, die 2023 ihre Expertise in die Fachjurys des Cannes Lions Festival of Creativity einfließen lassen!

-

#Wissen #Kinowerbung

KINO. MEIN ORT. Wie lassen sich Marken im Film und im Kino wirkungsvoll …

#Wissen #Kinowerbung

KINO. MEIN ORT. Wie lassen sich Marken im Film und im Kino wirkungsvoll …

-

#Corporate News #Cannes Lions Festival

Bewerbungsphase Young Lions 2023 startet mit neuer Kategorie Young Lions Wettbewerb 2023 gestartet! Jetzt bewerben unter www.younglions.de für …

#Corporate News #Cannes Lions Festival

Bewerbungsphase Young Lions 2023 startet mit neuer Kategorie Young Lions Wettbewerb 2023 gestartet! Jetzt bewerben unter www.younglions.de für …

-

#Corporate News

Stephanie Woesler wird neue Gesellschafterin bei Weischer Im Gesellschafterkreis verantwortet Stephanie Woesler seit dem 1. Januar die …

#Corporate News

Stephanie Woesler wird neue Gesellschafterin bei Weischer Im Gesellschafterkreis verantwortet Stephanie Woesler seit dem 1. Januar die …

-

#Corporate News #Out-of-Home

Weischer will neue Geschäftsfelder erschließen Udo Schendel wird Chief Investment Officer (CIO). Die Rolle des …

#Corporate News #Out-of-Home

Weischer will neue Geschäftsfelder erschließen Udo Schendel wird Chief Investment Officer (CIO). Die Rolle des …

-

#Corporate News #Kinowerbung

Cinedom in Köln: Völlig neue Erlebniswelten Der Cinedom in Köln wird zum Showcase der Kinowerbung: Marken …

#Corporate News #Kinowerbung

Cinedom in Köln: Völlig neue Erlebniswelten Der Cinedom in Köln wird zum Showcase der Kinowerbung: Marken …

-

#Verantwortung

Global Week to #Act4SDGs – Weischer ist wieder dabei! Seit 2014 engagieren wir uns für die Sustainable Development Goals …

#Verantwortung

Global Week to #Act4SDGs – Weischer ist wieder dabei! Seit 2014 engagieren wir uns für die Sustainable Development Goals …

-

#Cannes Lions Festival

Deutsche Juror:innen Eurobest 2022 stehen fest Insgesamt 10 deutsche Jurymitglieder ziehen dieses Jahr in die Eurobest …

#Cannes Lions Festival

Deutsche Juror:innen Eurobest 2022 stehen fest Insgesamt 10 deutsche Jurymitglieder ziehen dieses Jahr in die Eurobest …

-

#Corporate News #Verantwortung

Nachhaltigkeitsbericht auf alten Werbeplakaten Weischer veröffentlicht einen Nachhaltigkeitsbericht. Das Besondere: Das graphisch aufwendig gestaltete …

#Corporate News #Verantwortung

Nachhaltigkeitsbericht auf alten Werbeplakaten Weischer veröffentlicht einen Nachhaltigkeitsbericht. Das Besondere: Das graphisch aufwendig gestaltete …

-

#Corporate News #Out-of-Home

Kampagne gegen Obdachlosigkeit in Köln Weischer.JvB in Köln, Wall und die KreativRealisten initiieren gemeinsam eine …

#Corporate News #Out-of-Home

Kampagne gegen Obdachlosigkeit in Köln Weischer.JvB in Köln, Wall und die KreativRealisten initiieren gemeinsam eine …

-

#Corporate News #Kinowerbung

“Leuchtspuren” werden fortgesetzt Die Kino-Initiative „Leuchtspuren“ hat sich zum Liebling der Kinogänger entwickelt. …

#Corporate News #Kinowerbung

“Leuchtspuren” werden fortgesetzt Die Kino-Initiative „Leuchtspuren“ hat sich zum Liebling der Kinogänger entwickelt. …